Mark Zuckerberg zeichnet diese Vision seit vielen Jahren: Eines Tages werden wir schicke AR-Brillen tragen, die Hologramme in die Welt projizieren und Objekte ersetzen, die nicht unbedingt in physischer Form existieren müssen. Dazu könnte auch jede Art von Bildschirm gehören.

Mit Quest 3, dem ersten erschwinglichen Mixed-Reality-Headset, geht Meta den ersten Schritt in diese Richtung. Das Gerät fängt die physische Umgebung mit Sensoren ein und reproduziert sie in digitaler Form auf den Displays, wo sie beliebig manipuliert und erweitert werden kann. Zum Beispiel um virtuelle Bildschirme, die bei Bedarf in der wirklichen Umgebung verankert werden können. Etwa an der Wand oder in der Nische, wo der physische Fernseher steht.

Diese Art digitaler Mischrealität ist noch weit von Alltagstauglichkeit entfernt. Quest 3 ist ein schweres Headset, keine Brille und die Auflösung und Darstellungstreue der reproduzierten physischen Welt ist längst nicht perfekt. Und dann wäre noch die Software selbst, die Zuckerbergs Vision hinterherhinkt.

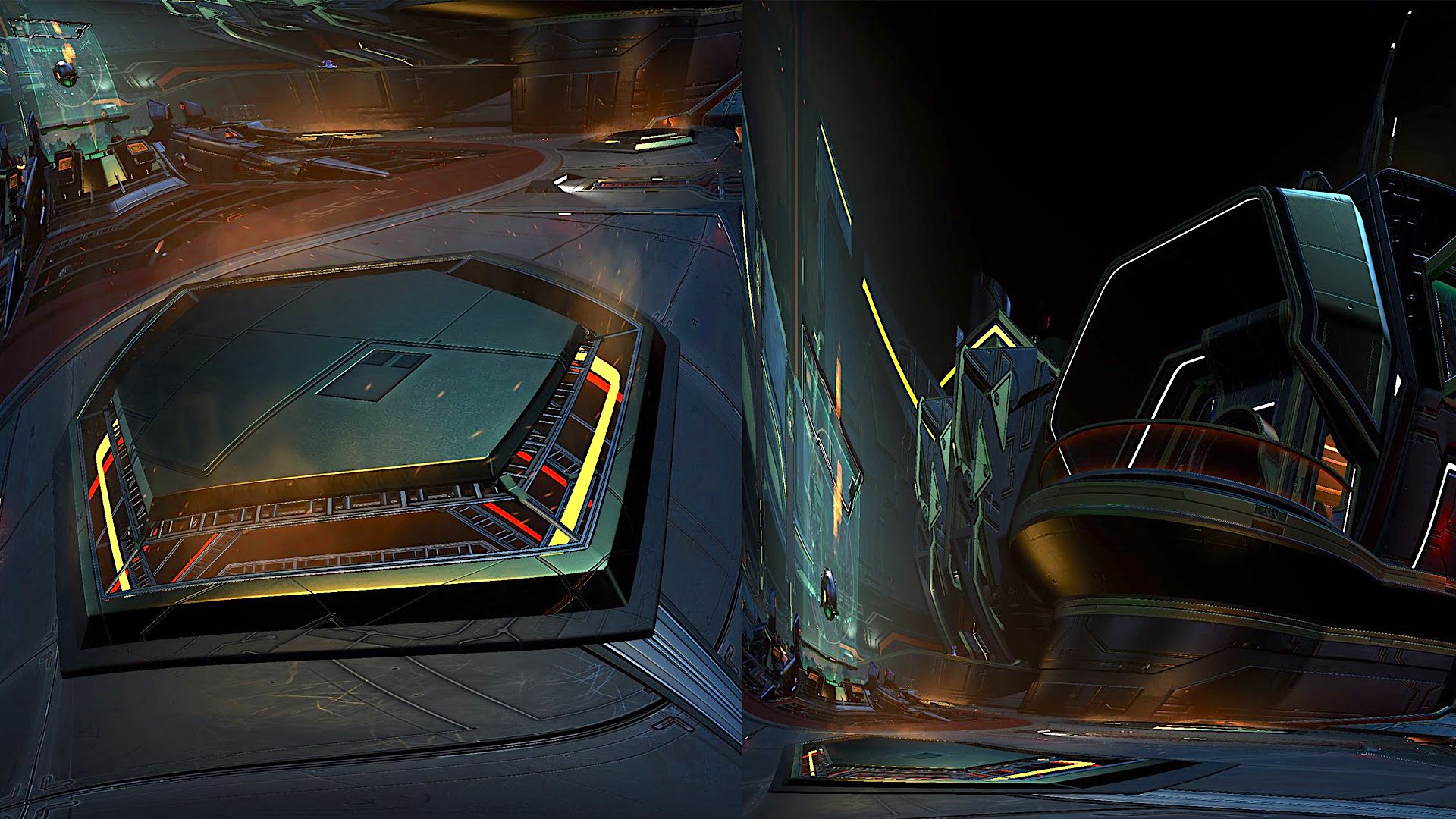

Der US-Entwickler Thomas Ratliff kann an den ersten beiden Dingen nichts ändern, aber mit ein paar Software-Tricks hat er einen virtuellen Bildschirm geschaffen, der schon jetzt täuschend echt wirkt. Auf Twitter zeigt er einen Mixed-Reality-Screen, der Global Illumination und Reflexionen in Echtzeit unterstützt. Man beachte, wie der Bildschirm nahe Oberflächen realistisch erhellt und wie sich das Bild auf dem Tisch spiegelt.

Zwei Einschränkungen hat die Techdemo: Zum einen wird der Bildschirm laut Ratliff auf einem PC und nicht nativ auf Meta Quest 3 gerendert. Zum anderen handelt es sich nur um einen Videoplayer, keinen Nintendo-Switch-Emulator oder eine andere App, die Spiele in Echtzeit rendert.

Ratliff schreibt auf Twitter, dass er sein Programm möglicherweise weiterentwickeln und in Metas App Lab oder auf Sidequest veröffentlichen will. Möglicherweise kommt ihm auch jemand zuvor. Schließlich gibt es bereits eine Reihe von Videoplayer-Apps für Meta Quest 3. Die äußerst beliebte App Virtual Desktop, mit der man den PC-Bildschirm in das Headset streamen kann, unterstützt bereits die Passthrough-Ansicht. Auch Youtube VR könnte ein entsprechendes Feature bringen oder Meta selbst. All das ist nur eine Frage der Zeit und Schnittstellen-Unterstützung seitens Meta.

Ob realistische virtuelle Monitore Mixed-Reality-Headsets wie der Quest 3 und der kommenden Apple Vision Pro zum Durchbruch verhelfen werden, ist fraglich, aber ein unabdingbares Feature auf ihrem Weg zum ultimativen Display sind sie allemal.

Dieser Beitrag erschien am 30. Oktober 2023 bei MIXED.