Handtracking wird die Art und Weise verändern, wie wir in und mit VR und MR interagieren, darin sind sich die meisten Experten einig. Umstrittener ist, wie gut Handtracking heute funktioniert und wie lange es dauern wird, bis es sich auf breiter Basis durchsetzt und Controller als primären Input ablöst – oder ob es das überhaupt jemals tun wird.

Einige Industrievertreter glauben, dass Handtracking die Branche bereits in zwei Jahren komplett umkrempeln wird, andere sind skeptischer. Zusätzlich angeheizt wurde die Debatte durch die Markteinführung der Apple Vision Pro, die nur auf Blick- und Handsteuerung setzt. Inzwischen hat sich der Wirbel um das Gerät gelegt. Apples räumlicher Computer, so viel ist klar, wird die VR-Industrie nicht über Nacht verändern und hat das Bewusstsein für die Vorteile von Controllern (Präzision, Haptik) eher geschärft als geschmälert.

Damit Handtracking zur primären Eingabemethode werden kann, muss es für die breite Bevölkerung weitgehend fehlerfrei und intuitiv nutzbar sein. Um die Probe aufs Exempel zu machen, habe ich mir eine Testperson gesucht: Meine Nachbarin und gute Freundin Esther, die im Ruhestand lebt und keine Erfahrung mit VR, Handtracking oder Videospielen hat.

Handtracking wird für seine Zugänglichkeit gefeiert. Wenn Esther als komplette Anfängerin mit der Technik klarkommt, dann sollte Handtracking nichts mehr im Wege stehen, richtig?

Ich ließ Esther etwa eine Stunde lang mit dem Handtracking von Meta Quest 3 experimentieren. Zuerst habe ich sie durch das Handtracking-Tutorial der Meta Quest geführt. Esther verstand sofort das Konzept des Touch-Inputs, das sie von mobilen Geräten kennt, aber es funktionierte nicht immer so, wie sie es sich vorstellte. Bestimmte Elemente musste sie zum Beispiel mehrmals auswählen und antippen, bevor das System die Eingabe richtig interpretierte. Die Gesten wiederum konnte sie sich relativ schnell einprägen.

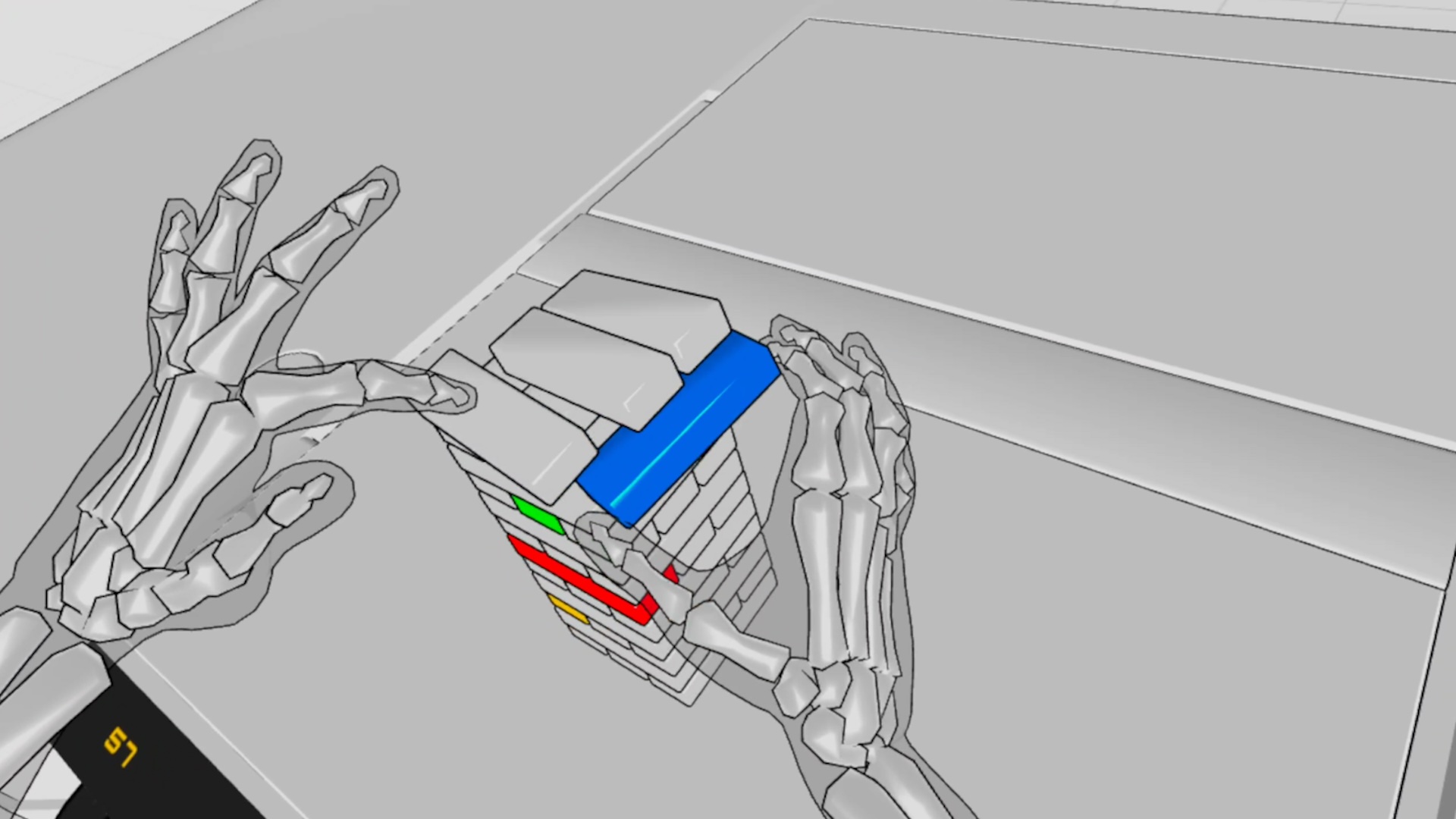

Ein Jenga-Spiel in Hand Physics Lab. | Bild: Dennys Kuhnert – Holonautic

Auf meine Frage, wie sie die Nutzererfahrung fand, meinte sie: „Es war in Ordnung, ich fand es nicht besonders einfach. Ich dachte, es könnte einfacher sein. Aber nachdem ich ein paar Mal gesehen habe, wie es funktioniert, war es nicht schwer, sich die Gesten zu merken.“

Als Nächstes probierten wir Vacation Simulator aus. Das VR-Spiel bietet seit 2020 experimentelle Unterstützung für Handtracking, das seit dem jüngsten Update vom Mai 2025 ein reguläres Feature ist. Die zehn Minuten in der Imbissbude waren für Esther recht anstrengend und am Ende konnte sie nicht einmal den Hotdog zubereiten, um den ich sie bat. Die meisten Zutaten lagen auf dem Boden verstreut.

Was Esther mit ihren Händen zu tun beabsichtigte und was das Spiel als Handlung interpretierte, waren oft zwei völlig verschiedene Dinge. Sie bezeichnete die Erfahrung als „frustrierend“, meinte jedoch, dass sie sich vorstellen könne, in diese Welt zurückzukehren und diese beim zweiten und dritten Mal mehr zu genießen, weil sie noch ein „völliger Neuling“ auf diesem Gebiet sei. Das Handtracking war in diesem Fall also eher ein Hindernis für den Spielspaß.

Das Puzzlespiel Cubism gefiel Esther besser, aber auch hier hatte sie Schwierigkeiten, die eher mit der Handtracking-Technik als mit dem Spiel zu tun hatten. Nach einigen Versuchen fiel es ihr relativ leicht, die Puzzleteile mit den Fingern zu greifen. Schwieriger war es, sie an der richtigen Stelle wieder loszulassen, da das Headset die Bewegung nicht immer erkannte und die Puzzlesteine an den Fingern „festklebten“, wie sie sagte.

Das Beispiel zeigt, dass Handtracking nicht einfach etwas ist, das funktioniert, sondern zuerst gelernt werden muss. Es reicht nicht, dass man ein Objekt einfach greift und loslässt. Man muss es auf eine bestimmte Weise greifen und loslassen. Dies ist eine Hürde, die Handtracking noch nehmen muss.

Cubism, hier auf einer Quest 2 mit monochromem Passthrough gespielt. | Bild: Thomas Van Bouwel

Feinste Bewegungen, die schlecht erkannt oder von den Computer-Vision-Algorithmen falsch interpretiert werden, sind ein Problem. Ein anderes Problem ist, wenn das System Bewegungen der Hände überinterpretiert und als Interaktionen auslegt, die gar nicht als solche beabsichtigt sind. Ein Phänomen, das der VR-Entwickler Antony Vitillo treffend als Midas-Problem bezeichnete (der habgierige Midas wünschte sich, dass alles, was er anfasste, zu Gold wurde. Als selbst Speisen und Getränke zu Gold wurden und er zu verhungern drohte, bat er den Gott Dionysos, den Wunsch zurückzunehmen). Auch mit diesem Problem hatte Esther in unserem Handtracking-Experiment zu kämpfen.

Der Test endete mit der VR-App Hand Physics Lab, die Esther ein Lächeln ins Gesicht zauberte. Der Handtracking-Experimentierkasten lebt mehr als die anderen Apps von den Unzulänglichkeiten der Technik, was es leichter macht, darüber hinwegzusehen.

Mein Fazit ist, dass Handtracking noch immer in der Experimentierphase steckt. VR-Enthusiasten kennen die Unzulänglichkeiten und wissen, wie man sie umgeht. Einsteiger, die viel Geld für ein Gerät ausgeben, haben einen anderen Anspruch: Es muss einfach funktionieren, vor allem, wenn es die primäre Eingabemethode sein soll. Handtracking wird erstens erst dann gereift sein, wenn es sich anfühlt, als würden wir tatsächlich mit unseren Händen interagieren, anstatt lernen zu müssen, sie so zu nutzen, dass sie das System richtig auslegt. Zweitens muss es fehlerfrei arbeiten. Es ist nicht genug, wenn etwa ein Knopfdruck in 90 Prozent der Fälle erkannt wird. Das ist frustrierend.

Und für die Ingenieurinnen und Ingenieure wird die Aufgabe schwieriger und nicht leichter: Die Erkennung in den nächsten Jahren von 90 auf 99,9 Prozent zu bringen, dürfte wesentlich schwieriger werden als von 0 auf 90 Prozent. Vor diesem Hintergrund kann ich mir nicht vorstellen, dass Meta demnächst damit beginnt, Quest-Headsets ohne Controller zu verkaufen. Aber auch was die Inhalte betrifft, muss noch viel passieren, bis Handtracking allgemein akzeptiert wird. Die allermeisten VR-Apps setzen aus gutem Grund immer noch Controller voraus.

Dieser Beitrag erschien am 16. Juli 2024 bei MIXED.